هل توظف أمريكا روبوت الدردشة المثير للجدل في دعم قدراتها العسكرية.. الذكاء الاصطناعي “القاتل”

رفضت شركة OpenAi، أوبن أيه آي، الإجابة عن تساؤلات بشأن استخدام البنتاغون برنامج الدردشة "شات جي بي تي"، القائم على الذكاء الاصطناعي، لأغراض عسكرية، فماذا يعني ذلك؟

Table of Contents (Show / Hide)

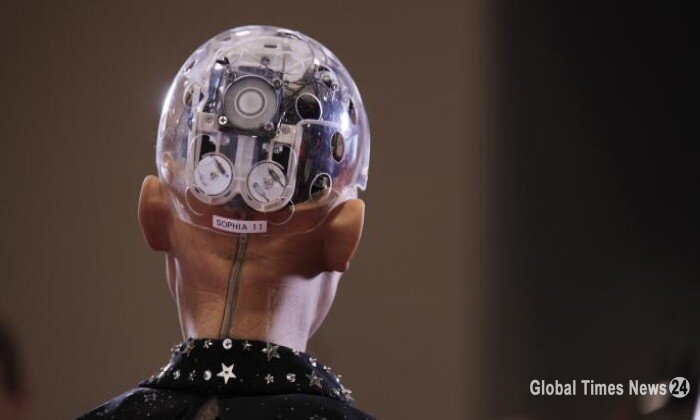

كان "ChatGPT" أو روبوت الدردشة القائم على الذكاء الاصطناعي، الذي تصنعه شركة "أوبن أيه آي"، في كاليفورنيا، قد أثار عاصفة من الجدل هذا العام، تبعتها تحذيرات خطيرة من جانب مشاهير ومتخصصين في مجال التكنولوجيا.

كما خلصت دراسة استقصائية حديثة إلى أن 50% من الباحثين العاملين في مجال الذكاء الاصطناعي يرون أن هذه التكنولوجيا يحتمل بنسبة 10% أن تتسبب في انقراض الجنس البشري.

ونشرت صحيفة The Times البريطانية تقريراً يرصد أبرز سبب للخوف من هذه التكنولوجيا، وهو أن لديها القدرة على اختراق العديد من مجالات حياتنا وإحداث أضرار مؤثرة فيها، سواء أكان ذلك بالتدمير المحتمل لكثير من الوظائف أم بتطوير أنظمة الأسلحة المستقلة [قليلة التدخل البشري]، التي يمكن أن تنتهك قوانين الحرب.

البنتاغون وتوظيف "شات جي بي تي"

في هذا السياق، نشر موقع The Intercept الأمريكي تقريراً يرصد سعي وزارة الدفاع الأمريكية (البنتاغون) لتوظيف روبوت الدردشة شات جي بي تي ChatGPT، في تعزيز قدراتها، بالنظر إلى التطور المتسارع والتحول المذهل لمولِّدات النصوص الآلية، من مجرد تصورات خيالية إلى مشروعات واقعية، ثم إلى أدوات حقيقية، ومن ثم صار من المحتوم أن تصل هذه الأدوات بعد ذلك إلى المرحلة التالية: مرحلة استعمالها سلاحاً بين الخصوم.

وبالفعل، يخطط البنتاغون ووكالات الاستخبارات الأمريكية علناً لاستخدام أدوات الذكاء الاصطناعي، مثل ChatGPT، لتعزيز قدراتها، إلا أن الشركة المنتجة لبرنامج الدردشة ذائع الشهرة لا تزال صامتة عن الأسئلة المرتبطة بذلك.

تقدم شركة OpenAI- عملاقة البحث والتطوير في مجال الذكاء الاصطناعي، والتي تبلغ قيمتها السوقية قرابة 30 مليار دولار، والمنتجة لتطبيق ChatGPT- قائمة عامة بالخطوط الأخلاقية التي لن تتجاوزها، والصفقات التجارية التي لن تعقدها مهما كانت مربحة، ما دام أنها قد تضر بالناس.

ومن بين هذه المحظورات، قالت شركة OpenAI إنها بادرت باستبعاد أي استخدام لمبتكراتها في التطبيقات العسكرية وغيرها من التطبيقات الحكومية "عالية الخطورة".

وفي هذا السياق، بدا أن الشركة تحذو حذو منافسيها، جوجل ومايكروسوفت، في الحرص على الترويج لتمسُّكها بالقيم السامية، ولكنها- مثلهم أيضاً- غير راغبة في مناقشة مضمون هذه القيم المزعومة ولا مقتضيات ممارستها بجدية، وكيف- أو حتى إن كانت- ستُنفذ حقاً.

تحدَّث موقع The Intercept الأمريكي إلى خبراء في سياسات الذكاء الاصطناعي، فقالوا إن صمت الشركة عن إجابة هذه الأسئلة يكشف عن الضعف المتأصل في تدابير التنظيم الذاتي التي تحتكم إليها شركات الذكاء الاصطناعي، إذ تسمح تلك المعايير الفضفاضة للشركات مثل OpenAI بأن تظهر في صورة الشركة المحكومة بمبادئ أخلاقية لا جدال فيها أمام الجمهور المتخوف من الذكاء الاصطناعي، ومع ذلك فإنها تطوِّر في الوقت نفسه تقنيات بالغة القوة لا يُعرف نطاق تأثيرها بعدُ.

وقالت سارة مايرز ويست، المديرة الإدارية لمعهد AI Now ومستشارة الذكاء الاصطناعي السابقة للجنة التجارة الفيدرالية الأمريكية، "الشيء الذي يجب أن نستنبطه من ذلك أنه من الخطأ بمكان أن نترك للشركات أمر مراقبة نفسها".

من جهة أخرى، فإن مسألة ما إذا كانت شركة OpenAI ستسمح بعسكرة تقنيتها أم لن تسمح، لم تعد مجرد مسألة أكاديمية. ففي 8 مارس/آذار، اجتمع أعضاء منظمة "تحالف الاستخبارات والأمن القومي" الأمريكية في شمال ولاية فرجينيا لحضور المؤتمر السنوي للمنظمة حول التقنيات الناشئة.

وحضر المؤتمر ممثلون لشركات خاصة ومسؤولون حكوميون- من البنتاغون ووكالات الاستخبارات خصوصاً- حرصاً منهم على معرفة السبل التي يمكن للأجهزة الأمنية الأمريكية أن تنضم بها إلى الشركات في جميع أنحاء العالم في تبني تقنيات التعلم الآلي بسرعة.

وقد شهد المؤتمر جلسة أسئلة وأجوبة، سُئل فيها فيليب شودوبا، المدير المساعد لشؤون التقنيات بـ"الوكالة الأمريكية للاستخبارات الجغرافية المكانية"، عن سبل الاستفادة المتوقعة لمؤسسته من الاعتماد على الذكاء الاصطناعي، فأجاب: "نحن جميعاً نتابع ChatGPT عن كثب، ونتطلع إلى التحول الذي ستحدثه هذه التقنية المفيدة والمخيفة في آن واحد. ونتوقع أن تتطور الأمور إلى نوع من التمازج بين كل ما نعرفه عن الاستخبارات الجغرافية المكانية والذكاء الاصطناعي والتعلم الآلي والتحليل القائم على المزج بين الذكاء الاصطناعي والتعلم الآلي، وما يوفره ChatGPT من قدرات على توقع أشياء غفلَ عنها المحلل البشري، ربما بسبب الخبرة، أو التحيز، وما إلى ذلك".

يقصد شودوبا بذلك أن تقنيات الذكاء الاصطناعي يمكن استخدامها لمعالجة مقدار هائل من المعلومات الجغرافية- مثل الخرائط وصور الأقمار الصناعية وبيانات الطقس وما شابه- لإعطاء الجيش ووكالات الاستخبارات صورة دقيقة لما يحدث على الأرض.

ما هي استخدامات الذكاء الاصطناعي المحظورة؟

لكن طموحات شودوبا في الاعتماد على الذكاء الاصطناعي من الواضح أنها ستواجه بعض الصعوبات، لأن شركة OpenAI المبتكرة لتكنولوجيا ChatGPT قد حظرت صراحةً استخدام هذه التقنية في تطبيقات "اتخاذ القرارات العسكرية والحربية"، و"اتخاذ القرارات الحكومية عالية الخطورة"، وفقاً لما ورد في صفحة "سياسات الاستخدام" الخاصة بالشركة.

وتقول سياسة الاستخدام أيضاً: "إذا اكتشفنا أن منتجك أو استخدامك لا يتبع هذه السياسات، فقد نطلب منك إجراء التغييرات اللازمة"، و"قد تستدعي المخالفات الجسيمة والمتكررة لسياساتنا إلى اتخاذ مزيدٍ من الإجراءات، التي قد تشمل تجميد حسابك أو إلغاءه".

وفي حين أن وكالة الاستخبارات الجغرافية الزمانية وغيرها من وكالات الاستخبارات الأمريكية الساعية إلى استغلال الذكاء الاصطناعي قد تلجأ في نهاية المطاف إلى التعاقد مع شركات أخرى، فإن الواقع أن عدداً قليلاً من الشركات المنافسة لشركة OpenAI تملك الموارد اللازمة لبناء تطبيق مثل ChatGPT 4.

ورغم أن الحظر الوارد في دليل سياسات شركة OpenAI قاطعٌ في حظره لاستخدام تطبيقات الشركة في المجالات الاستخباراتية، فإن الشركة ترفض التصريح بذلك عند سؤالها عن الأمر.

ولما سأل موقع The Intercept الرئيس التنفيذي لشركة OpenAI، سام ألتمان، عن رأيه في حديث شودوبا عن استخدام الذكاء الاصطناعي في عمل الاستخبارات، أحال ألتمان الإجابة إلى المتحدث باسم الشركة أليكس بيك، والذي لم يعلق على تصريحات شودوبا، ولم يجب عن أي أسئلة.

في غضون ذلك، قالت مايرز، من معهد AI Now Institute ، للموقع الأمريكي إن امتناع الشركة عن الإجابة عن هذا السؤال أمر مقلق للغاية، و"يتعارض بالتأكيد مع كل ما قالوه للجمهور عن تخوفهم من هذه المخاطر، وزعمهم بأنهم حريصون على المصلحة العامة. لأننا ما إن ندخل في التفاصيل إلا ونجد أنهم غير مستعدين للتحدث عن الأضرار التي قد يتعرضون لها، إن هم التزموا السياسات التي أعلنوها، وهذا يظهر هشاشة موقفهم إلى حد ما".

الاختلاف بين الواقع و"العلاقات العامة"

الواقع أنه حتى المبادئ الأخلاقية التي يُفترض أنها شديدة الوضوح في قطاع التكنولوجيا، قد تبين في غير مرة أنها ليست إلا دعاية ترويجية ضمن حملات العلاقات العامة لشركات التكنولوجيا، أكثر من كونها سياسة تحرص الشركات على التمسك بها. ومن الأدلة على ذلك أن شركة تويتر- على سبيل المثال- لطالما زعمت أن سياساتها تحظر استخدام التطبيق في التجسس على حسابات المستخدمين، لكن الواقع أنها كانت تسمح للسلطات الأمريكية بحق الوصول الكامل إلى حسابات المستخدمين ورسائلهم الخاصة.

أما شركة جوجل، فتبيع خدمات الذكاء الاصطناعي إلى وزارة الدفاع الإسرائيلية، في الوقت الذي تزعم فيه أن "مبادئ استخدام الذكاء الاصطناعي" المتبعة في تطبيقاتها تحظر بيع الخدمات "التي تسبب أو يحتمل أن تسبب ضرراً عاماً"، و"التي يتعارض غرضها مع مبادئ القانون الدولي وحقوق الإنسان".

كذلك، فإن سياسات الأخلاقيات العامة لشركة مايكروسوفت تدعي "الحرص على اتباع السياسات التي تخفف من آثار التغير المناخي"، ومع ذلك فإنها تساعد شركة "إكسون موبيل" في تحليل بيانات حقول النفط، فضلاً عن أنها تزعم "حرصها على مراعاة الفئات المستضعفة"، ومع ذلك تبيع أدوات المراقبة للشرطة الأمريكية.

ماذا تعني تلك الأحداث؟

أحد الأسباب التي تدعو للتخوف من ChatGPT وغيره من التطبيقات المماثلة، هو ما بات معروفاً عن تكنولوجيا الذكاء الاصطناعي من اضطراب مخرجاته بشأن بعض الحقائق الأساسية وتوليد ردود تبدو معقولة، ولكنها مزيفة على الحقيقة. هذه التحليلات التي تبدو مقنعة، لكنها في الواقع "هراء مُقنع"، مشكلة كبيرة لخبراء الاستخبارات وغيرهم. علاوة على ذلك، فإن أدوات توليد النصوص، مثل ChatGPT، عاجزة في العموم عن شرح الكيفية التي توصلت بها إلى إجاباتها، ولماذا أنتجت هذه المخرجات على وجه التحديد.

بالإضافة إلى ذلك، قالت لوسي سوشمان، الأستاذة الفخرية في الأنثروبولوجيا والتكنولوجيا العسكرية في جامعة لانكستر، لموقع The Intercept أن تغذية نظام ChatGPT، والأنظمة الشبيهة، بآخر المعلومات المستحدثة عن العالم، يمثل عقبة أخرى. "[نماذج اللغات الكبيرة] الحالية مثل تلك التي تدعم ChatGPT هي عوالم مغلقة فعلياً من البيانات الرقمية بالفعل، ومن المعروف أن البيانات التي يعتمد عليها ChatGPT انتهى أمدها في عام 2021".

أوضحت سوشمان أن إعادة التدريب السريع للنماذج مشكلة لم تُحل حتى الآن. لذا فإن المشكلة المتعلقة بكيفية دمج البيانات، لا سيما في ظل الظروف سريعة التغير واضطرابات القتال الحربي على سبيل المثال، تبدو مشكلة كبيرة. ويزيد على ذلك مشكلات التنميط، وآفة الاستهداف القائم على معلومات مضللة تعتمد على البيانات [دون معلومات ميدانية] في المقام الأول، وهو أحد العيوب التي ابتليت بها الاستخبارات العسكرية الأمريكية في الوقت الحالي.

من جهة أخرى، فإن عدم استبعاد شركة OpenAI للتعاون مع الوكالة الأمريكية للاستخبارات الجغرافية المكانية أمرٌ مفيد للشركة تجارياً. فالصفقات الحكومية، وخاصة المتعلقة بالأمن القومي، مربحة للغاية لشركات التكنولوجيا؛ فقد وقعت شركات أمازون وجوجل ومايكروسوفت و"آي بي إم" و"أوراكل" في عام 2020 عقود تعاون مع وكالة الاستخبارات المركزية الأمريكية بعشرات المليارات من الدولارات؛ وشركة مايكروسوفت- التي استثمرت 13 مليار دولار في OpenAI وتعمل على دمج قدرات التعلم الآلي في محركها البحثي- كسبت عشرات المليارات من العقود العسكرية والاستخباراتية.

تدرك شركة OpenAI أن التعاون مع الشركات العسكرية والوكالات الاستخباراتية من الأمور التي ستثير جدلاً كبيراً بين موظفيها وبين جمهور المستخدمين عموماً. والشركة لديها في الوقت الحالي سمعة حسنة في جميع أنحاء العالم، بفضل أدواتها وألعابها الرائعة للتعلم الآلي، وهي صورة عامة لامعة سرعان ما ستتلوث إذا تعاونت الشركة مع البنتاغون.

ومع ذلك، فقد أشارت سوشمان إلى أن "العروض التي تقدمها الشركة عن نفسها تتماشى مع مزاعم الطهر الأخلاقي التي تقدمها شركات الذكاء الاصطناعي في البداية عن نفسها"، لكن الأخلاقيات التي تنسبها الشركات لنفسها في سياساتها التوجيهية يصعب التمسك بها بعد ذلك. و"عجز الشركة عن الرد على الاستفسارات الصحفية بشأن الأمر يدل على أنهم غير مستعدين لتحمل المسؤولية عن السياسات التي نسبوها إلى أنفسهم".

مارك زوكربيرغ يخطط لجولة جديدة من تسريح الموظفين.. الآلاف مهدَّدون بفقد وظائفهم في فيسبوك

مارك زوكربيرغ يخطط لجولة جديدة من تسريح الموظفين.. الآلاف مهدَّدون بفقد وظائفهم في فيسبوك

صحيفة ذا غارديان: الهواتف المحمولة تؤثر على الأعصاب والذاكرة بشكل مباشر

صحيفة ذا غارديان: الهواتف المحمولة تؤثر على الأعصاب والذاكرة بشكل مباشر

القوانين والمدن الذكية: أساليب الخنق المتجددة لآل سعود

القوانين والمدن الذكية: أساليب الخنق المتجددة لآل سعود

كشف عن موعد إصدار "آيفون 14"

كشف عن موعد إصدار "آيفون 14"

ماسك يتحدث عن تفاصيل تعامل "تويتر" مع فساد نجل بايدن

ماسك يتحدث عن تفاصيل تعامل "تويتر" مع فساد نجل بايدن

ماذا يعني دخول الذكاء الاصطناعي على خط التنافس بين الصين وأمريكا.. روبوت ChatGPT في قلب الصراع

ماذا يعني دخول الذكاء الاصطناعي على خط التنافس بين الصين وأمريكا.. روبوت ChatGPT في قلب الصراع

"نيويوركر": إيتمار بن غفير "وزير الفوضى في إسرائيل"

"نيويوركر": إيتمار بن غفير "وزير الفوضى في إسرائيل"

وثائق وصور تفضح تجنيد الإمارات شبكة تضليل وتحريض في أوروبا

وثائق وصور تفضح تجنيد الإمارات شبكة تضليل وتحريض في أوروبا

تطور مذهل للذكاء الاصطناعي.. هل يتسبب بأزمة اقتصادية وسياسية في الدول العربية

تطور مذهل للذكاء الاصطناعي.. هل يتسبب بأزمة اقتصادية وسياسية في الدول العربية

الإمارات تبني جيشا من المرتزقة بخبرات جنرالات أمريكيين

الإمارات تبني جيشا من المرتزقة بخبرات جنرالات أمريكيين