"TikTok aggrave les problèmes de santé mentale existants" chez les jeunes utilisateurs, alerte Amnesty International dans une étude

DEFI Selon un rapport publié par l’application, la santé mentale de près de 30 % des ados est affectée lorsqu’ils sont exposés à des contenus ayant rapport à la mort, à l’automutilation et au suicide

Table of Contents (Show / Hide)

Amnesty International a publié un rapport montrant que l'application enferme ses jeunes utilisateurs dans des microcosmes de vidéos liées à la dépression, ou, pire, l'automutilation et le suicide.

"Univers virtuel", "bulle de filtre" ou encore "terrier de lapin"; les noms sont nombreux pour cette caractéristique de Tiktok, qu'Amnesty International qualifie de "spirale". Cette faculté du réseau social chinois à enfermer ses utilisateurs est désormais connue des chercheurs, des associations de protection de l'enfance, voire du grand public.

Alors que des études ont déjà mis en lumière ce problème, un nouveau rapport d'Amnesty International, publié ce mardi 7 novembre, vient le confirmer - encore une fois. Cette étude a été réalisée conjointement avec l'Algorithmic Transparency Institute et AI Forensics, qui ont joué un rôle de "partenaires techniques", explique Amnesty International dans son rapport.

En créant de faux comptes basés sur le profil de mineurs, des chercheurs d'Amnesty International ont constaté à quel point l'application chinoise de courtes vidéos entraîne ses utilisateurs dans des microcosmes néfastes et faisant, parfois, l'apologie des syndromes dépressifs, de l'automutilation ou même du suicide.

Vrais et faux comptes

Pour réaliser cette étude, ils se sont entretenus avec plus de 300 enfants du Kenya, des Philippines et des Etats-Unis (les trois pays font partie de ceux ayant un très fort taux d'utilisation des réseaux sociaux), ont créé 30 faux profils automatisés dans un but d'analyse, ainsi que des comptes gérés "manuellement" pour les comparer avec ces derniers.

"L’équipe de recherche a créé 40 comptes automatisés avec quatre personas prédéfinies présentant divers degrés d’intérêt pour les contenus liés à la santé mentale, de façon à imiter différents comportements adoptés par des enfants sur TikTok", explique le rapport.

"Au bout de cinq ou six heures passées sur la plateforme, presque une vidéo sur deux présentée aux comptes automatisés, programmés pour simuler le comportement d'un enfant de 13 ans présentant un intérêt pour la santé mentale, était relative à ce sujet et potentiellement nocive, soit un volume dix fois plus important que celui des comptes n'ayant indiqué aucun intérêt pour le sujet", continue-t-il.

Pire pour les comptes manuels

Le constat est pire pour les comptes gérés manuellement. Le fait de gérer manuellement un compte permet d'adopter un comportement permettant à l'application d'encore plus affiner son algorithme de recommandation, par exemple en effectuant des recherches de mots-clés ou en revisionnant des vidéos.

L'algorithme de Tiktok est en effet particulièrement sensible au revisionnage: en regardant une vidéo deux fois de suite, le sujet de la vidéo va "entrer" dans les centres d'intérêt de l'utilisateur.

Sur les comptes manuels, qui ont revisionné des vidéos liées à la santé mentale, au bout de 12 minutes de défilement, "58% des contenus étaient liés à l'anxiété, la dépression, l'automutilation et le suicide". Ces contenus ont été catégorisés comme pouvant être néfastes pour des enfants et adolescents présentant déjà des troubles.

Dans l'un des cas les plus extrêmes, un compte géré manuellement s'est vu proposer, en une heure d'utilisation, au moins neuf publications qui "idéalisaient, banalisaient ou encourageaient le suicide". Pour contextualiser, en février dernier, un rapport indiquait que les jeunes entre 4 et 18 ans passent en moyenne deux heures quotidiennement sur l'application.

Concrètement, cela signifie qu'un adolescent qui s'intéresse à la santé mentale, par exemple parce qu'il se sent mal dans sa peau ou qu'il rencontre des troubles, va recevoir dix fois plus de vidéos sur le sujet, dont certaines pouvant être nocives et encourager des pratiques dangereuses.

"Poussées à l'automutilation"

Ainsi, le rapport mentionne que "des personnes ont indiqué avoir vu des publications qui, d'après elles, auraient exacerbé leur anorexie autodéclarée, qu'elles ont qualifiées de 'bouleversantes' et qui les auraient poussées à "l’automutilation" et leur auraient fait 'peur'". L'un des jeunes, interrogé par Amnesy, décrit "une spirale infernale, qui (ne) commence qu'avec une seule vidéo".

Le rapport pointe aussi du doigt l'aspect fortement addictif de l'application. L'algorithme de Tiktok, qui a fait son succès mais qui cristallise aussi ses conséquences néfastes, consiste à proposer de manière infinie des vidéos qui défilent.

Lorsqu'une vidéo se termine, elle recommence, et lorsqu'on "déroule" vers le bas, une autre apparaît, sans fin. Parmi les témoignages récoltés par Amnesty International auprès d'enfants, nombreux sont ceux qui admettent avoir développé une dépendance à l'application.

"Machines à sous"

"Je ne veux y passer que cinq minutes, mais les vidéos sont si intéressantes que je finis par regarder pendant au moins six heures", indique ainsi une jeune femme des Philippines.

Les mécaniques de Tiktok sont décrites comme similaires à celles des "machines à sous" par les psychologues sollicités par Amnesty International.

"Selon les résultats de recherches présentés ici, Tiktok pourrait exposer les enfants et les jeunes à des troubles du sommeil et de l'attention et pourrait contribuer à des modifications de la structure cérébrale analogues à celles observées chez les personnes souffrant d'une dépendance à la drogue", dénonce le rapport.

Mesures insuffisantes

Certes, le réseau social a mis en place, en février dernier, une limite de temps réservée aux mineurs. Au bout d'une heure d'utilisation, ces derniers doivent entrer un mot de passe pour continuer à l'utiliser. Une fonction jugée "limitée" par Amnesty, du fait qu'elle soit très facilement désactivable et que le fait de demander un mot de passe volontairement choisi n'incite pas forcément à couper l'application.

De plus, cette mesure est proposée uniquement aux utilisateurs identifiés comme mineurs par l'application. Or des études ont révélé que le dispositif de vérification de l'âge n'était pas systématiquement efficace (l'application demande simplement la date de naissance de l'utilisateur, qui peut mentir).

Cette étude fait écho à une recherche effectuée, en 2021, par le Wall Street Journal. Deux ans plus tard, les constats émis par Amnesty International sont similaires, voire pires que ceux du quotidien américain. Et ce, malgré les nombreuses mesures prises par le réseau social pour lutter contre ce problème connu de longue date.

Ce rapport d'Amnesty International ne fait que confirmer les inquiétudes déjà émises par divers acteurs: associations de protection de l'enfance, gouvernements, défenseur de la vie privée, ou même des parents. En France, le Sénat a mené pendant quatre mois une enquête sur l'application. Cette dernière avait donné lieu à un rapport alarmant, qui pointe aussi du doigt le caractère addictif de l'application et sa capacité à enfermer ses plus jeunes utilisateurs dans des bulles de filtres.

Tout ce que vous devez savoir sur la variole du singe

Tout ce que vous devez savoir sur la variole du singe

Accusé d’avoir aidé un ami à mourir, un vétérinaire a été relaxé : « Il n’a agi que par empathie et amitié »

Accusé d’avoir aidé un ami à mourir, un vétérinaire a été relaxé : « Il n’a agi que par empathie et amitié »

L'Agence du médicament entérine l'interdiction du HHC, dérivé du cannabis, en France

L'Agence du médicament entérine l'interdiction du HHC, dérivé du cannabis, en France

La Chine "submergée" face à une vague de contaminations au Covid-19

La Chine "submergée" face à une vague de contaminations au Covid-19

Cannabis : l’insomnie est deux fois plus fréquente chez les étudiants qui en consomment tous les jours, selon une étude

Cannabis : l’insomnie est deux fois plus fréquente chez les étudiants qui en consomment tous les jours, selon une étude

L’Assemblée générale a reconnu « l’injustice historique » qui a frappé le peuple palestinien

L’Assemblée générale a reconnu « l’injustice historique » qui a frappé le peuple palestinien

Face cachée des Émirats arabes unis : le rapport de HRW

Face cachée des Émirats arabes unis : le rapport de HRW

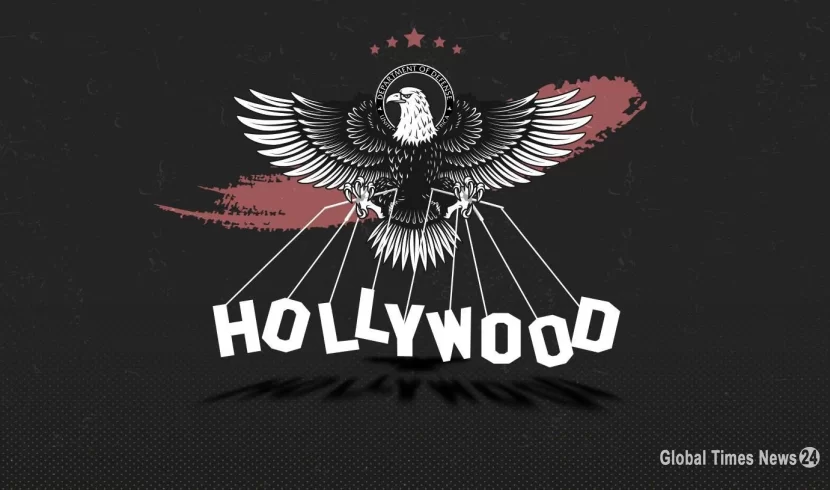

Quand le Pentagone dicte ses scénarios à Hollywood pour dissimuler les crimes de guerre du militarisme américain

Quand le Pentagone dicte ses scénarios à Hollywood pour dissimuler les crimes de guerre du militarisme américain

Algérie : le sort des défenseurs des droits humains est l'exil ou la prison

Algérie : le sort des défenseurs des droits humains est l'exil ou la prison

La meilleure façon d'arrêter de fumer – selon les conseils des médecins et ma propre expérience - 100% garantie

La meilleure façon d'arrêter de fumer – selon les conseils des médecins et ma propre expérience - 100% garantie